StableCode をリリースしました

Stability AI は、初のコーディング用 LLM 生成AI製品である StableCode をリリースしました。この製品は、プログラマーの日常業務を支援すると同時に、スキルを次のレベルに引き上げる準備ができている新人開発者向けの優れた学習ツールとしても設計されています。

“a colorful parrot with glasses typing away at a computer, flat icon, vector” – SDXL 0.9

StableCode は、3つの異なるモデルを使用してコーディングを支援することで、開発者がより効率的になるためのユニークな方法を提供します。ベースモデルは、まず BigCode のスタックデータセット(v1.2)から多様なプログラミング言語のセットでトレーニングされ、Python、Go、Java、Javascript、C、markdown、C++ のような一般的な言語でさらにトレーニングされました。 合計で、私たちの HPC クラスタ上の 560Bトークンのコードでモデルを訓練しました。

ベースモデルが確立された後、複雑なプログラミングタスクの解決を支援するためにインストラクションモデルをチューニングしました。この結果を達成するために、Alpaca 形式のおよそ120,000のコード命令/応答ペアをベースモデルで学習しました。

StableCode Instructを使用して、指定された命令に対する応答を生成するコード。

StableCode は、コーディングについてもっと学びたい人にとって理想的なビルディングブロックであり、ロングコンテキストウィンドウモデルは、単一行および複数行のオートコンプリート候補を確実にユーザーに提供するための完璧なアシスタントです。このモデルは、一度に多くのコード(16,000 トークンのコンテキストウィンドウを持つ以前にリリースされたオープンモデルの 2-4 倍)を処理できるように構築されており、ユーザーは最大 5 つの平均的なサイズの Python ファイルに相当するものを同時にレビューまたは編集することができます。

Pytorch ディープラーニングライブラリを利用した比較的複雑なパイソンファイルを完成させる StableCode(グレーのテキストはStableCodeの予測)。

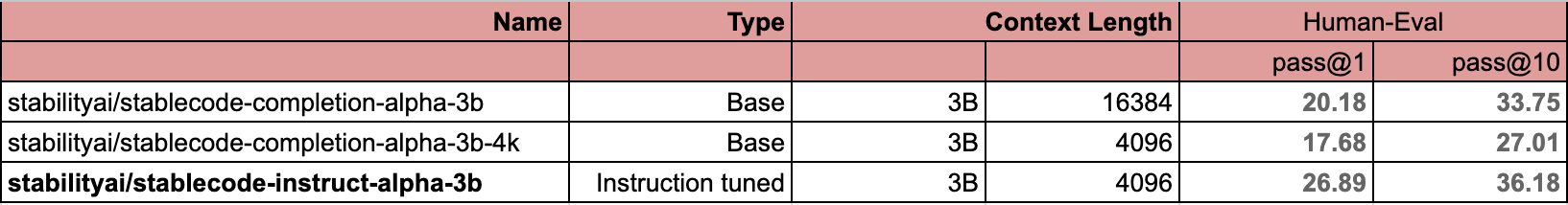

そして、同じようなパラメータ数とトークン数で学習された他のモデルとの比較です。一般的な HumanEval ベンチマークを使用し、標準的な pass@1とpass@10 のメトリクスを使用しています。

stablecode のベンチマークスコア

HumanEval ベンチマーク 同規模モデルとの比較(3B)

Stability AI はテクノロジーをより身近なものにすることを目指しており、StableCode はこの目標に向けた重要な一歩です。あらゆる背景を持つ人々が、AIを使って日常の問題を解決し、生活を向上させるためのコードを作成できるようになる日は近いでしょう。私たちは、StableCode が次の10億人のソフトウェア開発者がコードを学ぶ手助けになると同時に、世界中のテクノロジーへの公平なアクセスを提供することを願っています。

Stability AI Japan 公式 X (旧Twitter)では最新情報をお届けしています。ぜひフォローをお願いします。